400 606 5609

体验DEMO

400 606 5609

体验DEMO

400 606 5609

体验DEMO

400 606 5609

体验DEMO

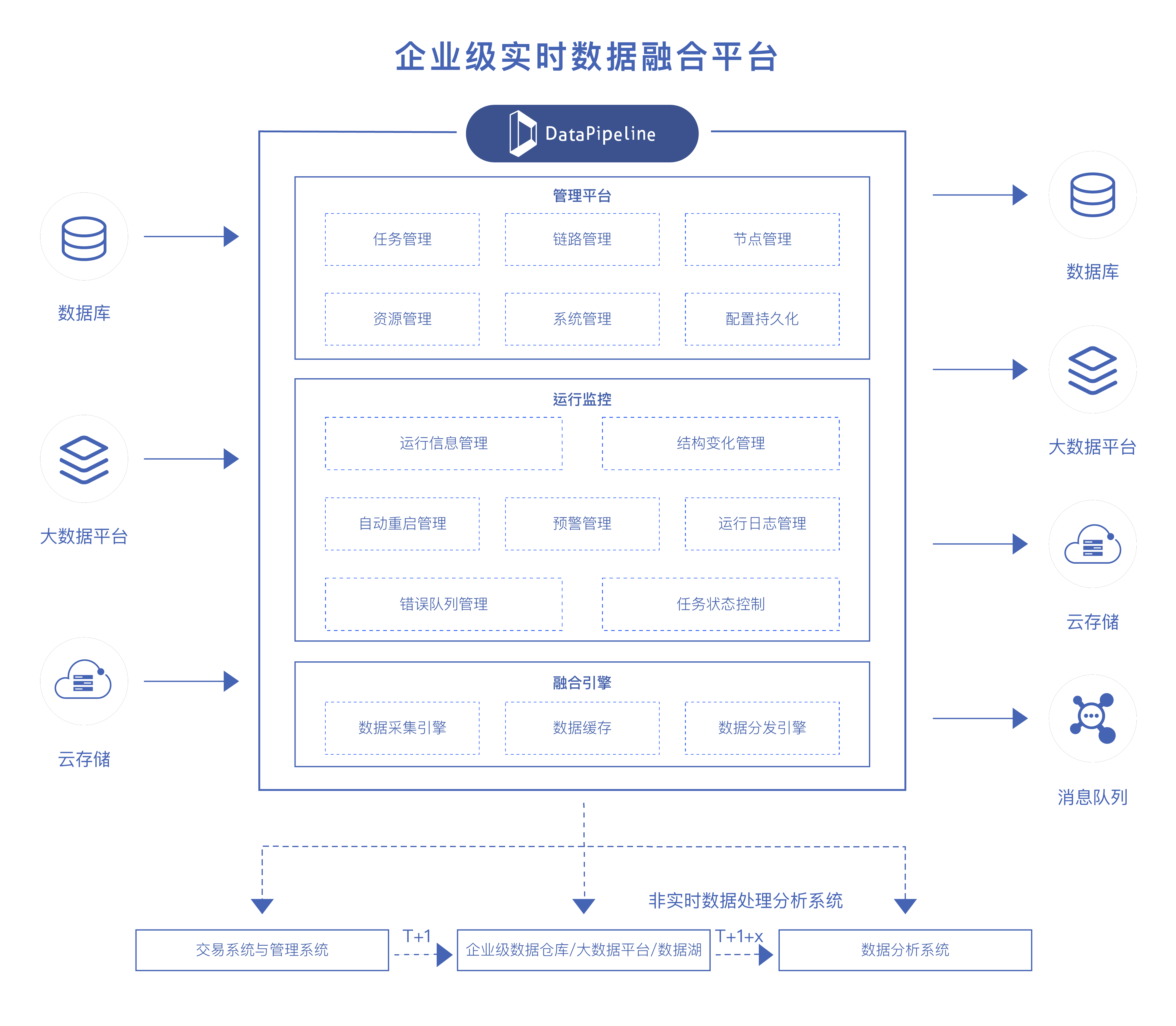

“为打造简捷、品质、温暖的服务品牌,持续优化和提升客户服务体验,公司积极践行科技创新驱动发展战略,通过“平台+服务”的方式,大力推进客户服务工作向着建设一站式、智能化、综合化服务生态目标发展。公司运用人工智能、大数据等技术实现数据融合,充分发挥数据价值,促进销售更加智能、精准和便捷。 DataPipeline利用实时数据管理产品与技术协助构建的企业级数据融合平台成功上线,在异构数据实时同步的准确性、系统的稳定性以及产品的兼容性几个点上很好地满足了我们的需求,实现了公司企业级实时数据的采集、融合与同步,为公司数字化转型奠定了坚实的基础。 存储在多种数据库中的异构数据被打通,海量的数据被汇聚、分发。数百个实时数据任务为从业务运营到经营决策的各个部门,从客户资源管理、精准营销、保障分析、大数据智能核保到智能理赔反欺诈等的各类场景提供准确、可靠、一致的批量与实时数据。未来,双方将在更多场景进行探索,推动更多实时应用落地。”

业务系统较多,核心系统产生的的海量数据,存放在异构系统中,需要大量人力进行数据整合与清洗。客户当前数据同步系统架构和性能都无法满足业务端实时取数和分析的需求。

没有可视化监控界面,无法查看同步的数据量,速率,每张表的同步状态等,定位问题难度大,费时久,发现错误难以调试,运维成本高。

将业务系统的数据实时同步至下游国产数据库,经过清洗加工后以API的形式供其他厂商、合作机构进行数据查询服务,查询的内容包括邮件往来通知、通知书信息(如问卷、访谈等),要求7*24小时不停机。

兼容客户的SQL Server、MySQL、TiDB等数据库,快速实现异构数据源之间实时增量数据同步。

保障高并发量下数据传输的稳定性和时效性。

通过DataPipeline可视化界面进行表的配置,省时且不容易出错;通过可视化监控界面,及时查看同步的数据量,速率,每张表的同步状态等,及时发现问题降低运维难度。

客户需要同步四种异构数据节点,自研至少需要数十个人月,成本较高。使用DataPipeline极大降低了研发成本且可以立即投入使用,得以将精力投入到数据价值的挖掘和释放上去。

提高业务端取数的实时性和丰富性,满足业务端实时大数据分析和业务需求。

DataPipeline简单易用,极大地加速了实时数据同步需求的开发配置和上线部署,实时数据的采集、加工均可以以配置的方式实现,一改过去项目制交付的弊端,降低手工开发成本,加快了实时数据价值的释放。