400 606 5609

体验DEMO

400 606 5609

体验DEMO

400 606 5609

体验DEMO

400 606 5609

体验DEMO

“DataPipeline助力我行打造的实时数据融合平台在多元异构数据节点的支持能力、批流一体数据同步能力、高可用性、可管理性具备突出能力,可实现高效连接复杂异构数据源和目的地、大数据量高并发的数据同步、可视化实时监测保障数据质量,有效地减少实时数据同步过程中的开发和运维成本,并提高了开发的工作效率。Datapipeline赋能我行经营、管理、服务、决策等领域创新变革,开启我行数智化转型新征程。”

数据存储和应用环境复杂,需要适配MySQL、Kafka、Hbase在内的多种数据库管理技术。

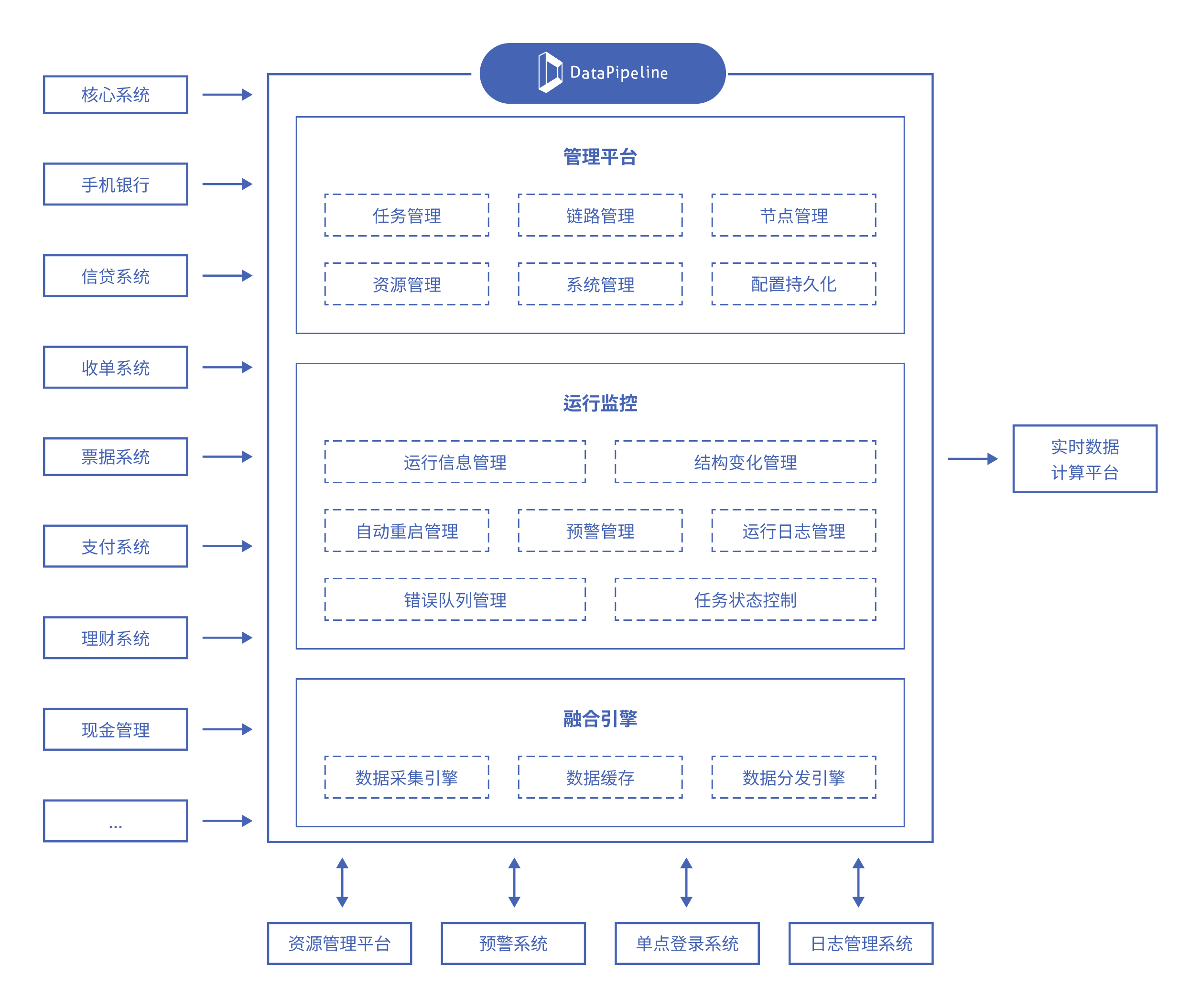

需要实现核心、支付、理财、现金、票据、收单等系统数据的实时采集与同步,接入实时数据计算平台,为上层数据模型构建与计算任务提供敏捷数据基础。

大规模数据处理不仅需要高效率的数据处理,还需要精细化的管理和维护,包括用户管理、单点登录、系统操作日志等。

对于数据任务的状态,客户需要实时监控和管理,包括激活、运行、暂停、报错、重启等状态。

支持关系型数据库、NoSQL数据库、国产数据库、数据仓库、大数据平台、云存储、API等多种数据节点类型,可自定义数据节点。

平台式统一集中管理,同时满足流和批的数据处理需求,支持指定增量同步、全量同步、执行时间同步等方式实现数据同步。支持基于日志的增量数据获取技术,实现秒级的变化数据捕获。

采用“数据节点注册、数据链路配置、数据任务构建、系统资源分配”的分层管理模式,大大缩短企业级平台的建设周期。平台提供用户管理、单点登录、系统操作日志等企业级管理能力,确保符合企业的整体管理要求。

数据任务的 “管理驾驶舱”功能,可以详细了解每个数据任务同步情况。 可实时监控上下游数据变化与异常情况,确保用户能够掌控激活、运行、暂停、报错、重启等数据任务状态。

能满足客户对于多样化数据源的处理需求,大大降低了客户的操作复杂度和技术门槛。

实现各系统的打通与关联,为行内资产管理、交易管理、电子回单等业务提供了实时敏捷的数据支撑,丰富了行内数据服务体系。

提供数据节点注册、数据链路配置、数据任务构建、系统资源分配等分层管理功能,帮助客户更高效地管理和维护数据任务,节省企业运营成本并降低风险。