400 606 5709

体验 DEMO

400 606 5709

体验 DEMO

400 606 5709

体验 DEMO

400 606 5709

体验 DEMO

2024年3月25日 • 作者:DataPipeline

一、项目背景与目标

在金融科技的推动下,数据驱动的创新模式已经成为重塑传统金融服务、提升市场效率和优化交易结构的重要力量。恒泰证券作为行业先行者,紧跟金融科技的步伐,经历了数字化转型的三大阶段。第一阶段,公司通过开放连接和科技赋能,实现了经纪业务的数字化获客转型,显著扩大了客户基础。第二阶段,公司专注于数字化运营,通过数据驱动提升了业务洞察力和敏捷运营能力,优化了客户运营和业务管理。第三阶段,公司致力于数字化财富管理,推动买方投顾模式的发展,并通过数字化运营模式支持金融产品服务的线上线下营销。

随着数字化转型的深入,恒泰证券认识到,为了保持竞争优势并满足日益增长的客户需求,建设一个稳定、高效且易用的数据融合平台变得至关重要。

▶ 技术目标

恒泰证券致力于实现关键业务系统间的实时数据同步和无缝对接,包括MOT平台(关键时刻服务管理平台)、ATP系统平台(综合业务平台)、交易日志、CRM系统平台(营销服务一体化平台)以及UF(证券核心交易系统)核心业务库等。同时,也希望强化平台的可扩展性和安全性,以适应未来业务发展和技术升级的需求。

▶ 业务目标

利用数据融合平台,提升经纪业务的财富管理能力和客户服务水平,增强客户满意度和忠诚度。通过数据驱动的洞察力,期望能够实现更精准的市场定位和产品推荐,推动买方投顾模式的进一步发展。此外,加强线上线下营销活动的协同效应,提高金融产品服务的市场竞争力,构建差异化的核心竞争力。

二、为什么选择DataPipeline

恒泰证券选择DataPipeline作为提升数据处理能力和业务创新的合作伙伴,主要基于DataPipeline的以下核心优势:

· 多元异构支持:兼容各类数据库和数据平台,包括关系型、NoSQL、国产数据库等,适应性强。

· 批流一体处理:提供统一的数据处理模式,简化了不同数据流管理的复杂性。

· 全面数据节点:支持自定义节点,灵活适应各种数据源,易于扩展。

· 高性能实时处理:确保TB级数据吞吐量和秒级低延迟,满足快速数据处理需求。

· 无代码敏捷管理:简化配置,缩短任务研发时间,提高效率。

· 高可用架构:分布式架构和容错策略保障系统稳定性和业务连续性。

三、实施方案

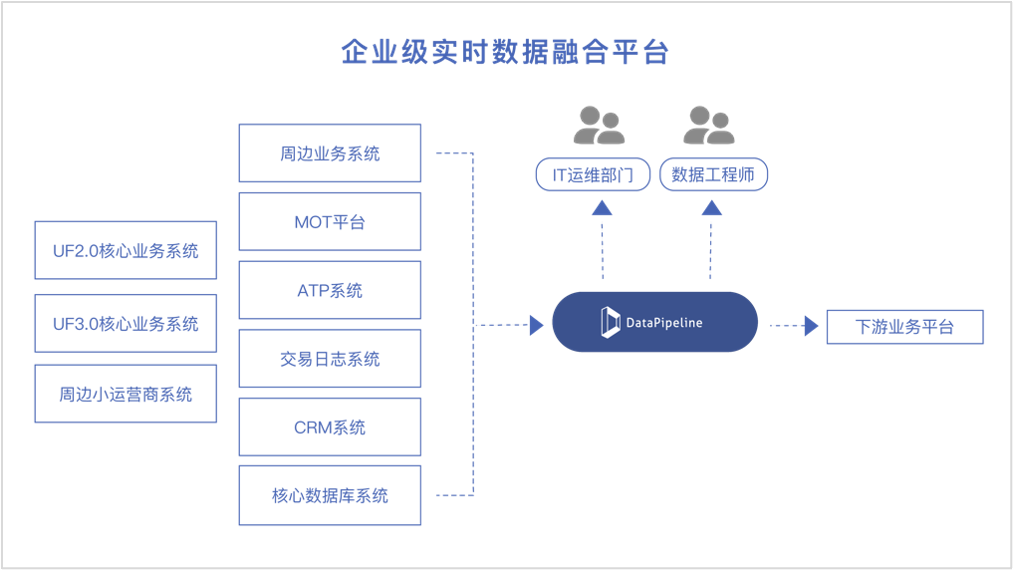

DataPipeline协助恒泰证券构建企业级实时数据融合平台,管理异构数据节点的实时同步与批量数据处理任务,适配了MySQL、Kafka、星环Hive在内的多种数据库管理技术,支持异构数据节点的实时同步与批处理。

实时数据融合平台架构

平台的TB级的数据吞吐能力和秒级处理速度,显著提高了数据在不同业务场景下的流转效率。通过无需编写代码的管理界面,使得数据融合任务的部署从以周计的周期大幅缩短至分钟级,有效降低了时间成本并提升了运营效率。此外,该平台采用分布式架构和全面的容错机制,确保了高度的可用性和可靠性,使得恒泰证券能够在各种不确定性环境中保持业务的连续性。

四、实施成果

经过两年多的稳定运行,DataPipeline企业级实时数据融合平台展现出显著的技术优势和业务价值。

在技术层面,平台运行稳定可靠,操作界面直观易用。特别是在数据库结构变更监测方面,使得上游DDL(数据定义语言)变更清晰可见,并允许灵活选择是否将变更应用到下游系统,有效支撑了公司实时业务的需求。

在业务层面,项目取得了以下成果:

· 业务流程优化:通过整合公司多个关键系统,实现了业务流程的无缝对接,显著提升了综合金融服务的效率和响应速度。

· 客户服务水平提升:构建了一个全面覆盖、多层次的客户服务体系,显著增强了在线上业务服务和资产配置方面的能力,为客户提供了更加高效和个性化的服务体验。

· 运维效率提高:通过数据同步任务的高效管理、及时的告警机制以及直观的图形化界面,日常任务监控变得更加简便,大幅节约了运维资源,提升了数据管理的效率,并有效释放了数据的潜在价值。

打造统一、稳定、可扩展的实时数据管理与计算能力底座,支撑核心业务、管理决策与风控场景的实时化升级

企业级实时数据底座的建立,使多源异构数据接入更加稳定高效,运维压力明显下降,架构弹性与扩展能力也得到全面提升。

项目不仅提高了运营效率,也让海信在用户服务和智能制造上具备了更强的前瞻能力。